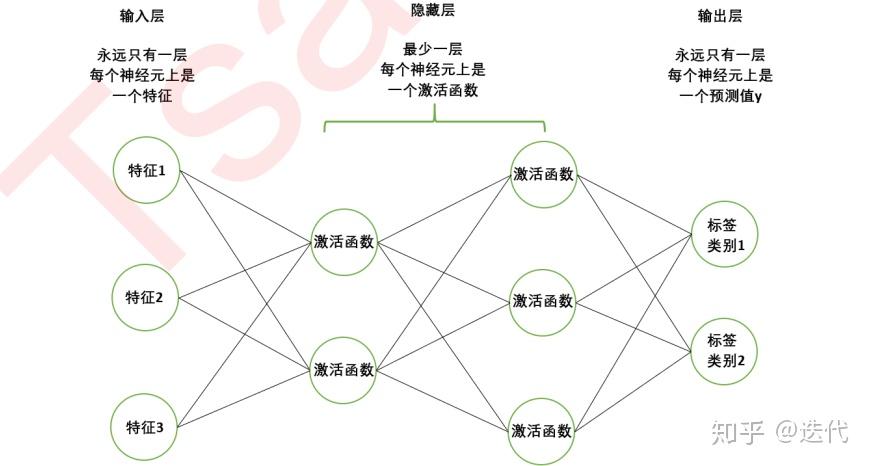

1、2 **双曲正切函数tanh**其图形与Sigmoid函数类似softmaxrelu和sigmod区别,但输出均值为0softmaxrelu和sigmod区别,这使得收敛速度比Sigmoid更快tanh同样具有软饱和性,可能导致梯度消失问题3 **ReLU 函数**一种简单高效的激活函数,输出正数原样输出,负数置零计算上更省资源,但存在激活函数死区问题,即在负数区域神经元几乎不激活softmaxrelu和sigmod区别;sigmoid和tanh各有优缺点,sigmoid在早期应用较多,但容易出现梯度消失问题,而tanh则相对稳定,收敛速度较快5 激活函数相关问题总结ReLU在0点不可导,但实际应用中通常使用左导数或右导数,以避免导数不存在的错误tanh的收敛速度比sigmoid快,因为tanh的梯度消失问题不如sigmoid严重sigmoid和softmax的softmaxrelu和sigmod区别;总体而言,sigmoid函数适用于二分类,tanh适用于多分类,而reluswishsoftmax等则在深层网络中表现出色选择合适的激活函数依赖于具体任务的特性和网络的深度对于relu,使用时需注意learning rate的设置,避免神经元“死亡”通过上述讨论,softmaxrelu和sigmod区别我们可以清晰地理解这些激活函数的原理和适用场景,为实际应用提。

2、总结**不同函数根据具体问题需求网络架构及数学特性选择ReLU及其变体因其简单高效而广泛应用于隐藏层,SoftmaxSigmoid和Tanh在输出层中用于概率估计与解释,而Leaky ReLU和ELU则通过改进激活函数特性提升模型性能。

本文仅代表作者观点,不代表百度立场。

本文系作者授权百度百家发表,未经许可,不得转载。

发表评论